進(jìn)入2023年后�����,以ChatGPT為代表的生成式人工智能市場的瘋狂擴(kuò)張�,在讓AI服務(wù)器需求迅速增加的同時�����,也帶動了HBM3、DDR5等高階產(chǎn)品的銷售上揚(yáng)��。0Svesmc

存儲廠商的“新”搖錢樹

TrendForce的調(diào)研顯示����,HBM現(xiàn)在幾乎已成為高端AI服務(wù)器GPU的標(biāo)準(zhǔn)配置,預(yù)估今年全球HBM的年需求量將增長約60%��,即從2022年的1.81億GB增加到2.9億GB�,2024年還將再成長30%。0Svesmc

目前�,谷歌、亞馬遜�、微軟等涉足云服務(wù)器業(yè)務(wù)的全球科技巨頭越來越多地采用HBM產(chǎn)品,尤其是HBM2E��。芯片廠商中��,NVIDIA A100/A800�����、AMD MI200芯片均采用HBM2E���;NVIDIA H100和AMD MI300X采用了SK海力士數(shù)據(jù)速率為5.6GT/s的12層24GB HBM3�;SK海力士、三星和美光三家存儲芯片大廠則分別以50%���、40%���、10%的比例瓜分了全球HBM市場份額。0Svesmc

HBM技術(shù)于2013年推出�,是一種高性能3D堆棧DRAM構(gòu)架,數(shù)據(jù)傳輸速率大概可以達(dá)到1Gbps左右��。此后�����,該技術(shù)標(biāo)準(zhǔn)差不多每隔2-3年就會更新一代�����,使得第二代(HBM2)�、第三代(HBM2E)、第四代(HBM3)和第五代(HBM3E)產(chǎn)品的帶寬和最高數(shù)據(jù)傳輸速率記錄被不斷刷新�。鑒于同期內(nèi)其他產(chǎn)品的帶寬僅增加兩到三倍���,我們有理由將HBM產(chǎn)品的快速發(fā)展歸功于存儲器制造商之間激烈的競爭�����。0Svesmc

早在2021年�����,SK海力士和Rambus就已先后發(fā)布最高數(shù)據(jù)傳輸速率6.4Gbps和8.4Gbps的HBM3產(chǎn)品�����,每個堆棧提供超過665GB/s和1075GB/s的傳輸速率����;今年4月,SK海力士成功實(shí)現(xiàn)垂直堆疊12個單品DRAM芯片��,最高容量24GB的HBM3 DRAM新產(chǎn)品����;7月,美光最新出樣的8層堆疊24GB容量第二代HBM3內(nèi)存帶寬超過1.2TB/s�,引腳速率超過9.2Gb/s,能使大型語言模型的訓(xùn)練時間縮短30%以上�����。 0Svesmc

0Svesmc

0Svesmc

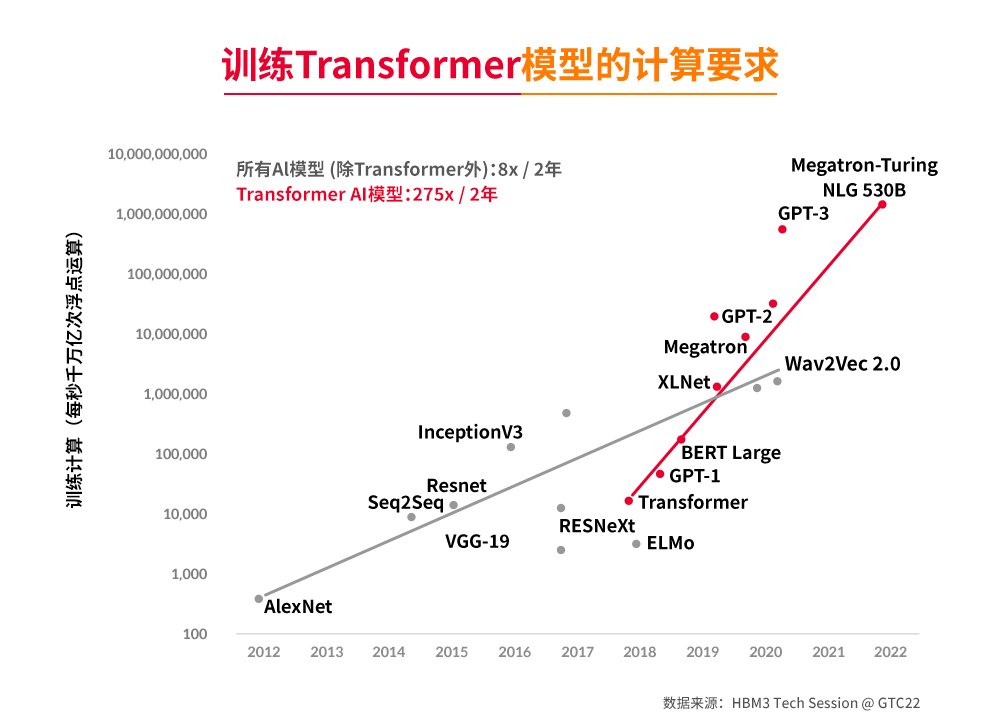

訓(xùn)練模型的計(jì)算性能趨勢(來源:SK hynix Tech Session @GTC2022)0Svesmc

相關(guān)機(jī)構(gòu)預(yù)測稱,SK海力士和三星的下一代產(chǎn)品�����,包括HBM3和HBM3E����,將在明年主導(dǎo)相關(guān)芯片市場。而為了滿足需求�����,三星和SK海力士不但預(yù)計(jì)將于今年下半年到明年第一季度期間發(fā)布HBM3E樣品�,并于2024年下半年開始量產(chǎn),還計(jì)劃于明年將HBM芯片產(chǎn)量提高一倍�����,并減少其他類別存儲芯片的投資�����,尤其是庫存水平較高���、盈利能力差的NAND��。0Svesmc

《BusinessKorea》在最近的一則報道中指出���,為了實(shí)現(xiàn)上述目標(biāo),兩家公司計(jì)劃在明年年底前投資超過2萬億韓元�。其中,SK海力士計(jì)劃利用利川現(xiàn)有HBM生產(chǎn)基地后的清州工廠的閑置空間����,三星電子正在考慮擴(kuò)大位于忠清南道天安市的HBM核心生產(chǎn)線,該地區(qū)是設(shè)備解決方案部門下的先進(jìn)封裝團(tuán)隊(duì)的所在地��。0Svesmc

雖然三星和SK海力士沒有透露HBM的具體價格�����,但據(jù)SemiAnalysis披露�,HBM3的價格大約是標(biāo)準(zhǔn)DRAM芯片的5-6倍,預(yù)計(jì)到2026年�,HBM占全球內(nèi)存收入的比例將從當(dāng)前的不到5%增長到20%以上。這就是為什么今年HBM出貨量僅占DRAM總出貨量的1.7%����,但其銷售額比例卻達(dá)到了11%����,英偉達(dá)����、AMD、微軟���、亞馬遜等芯片大廠排隊(duì)搶貨��,甚至溢價也可考慮的原因��。0Svesmc

這樣的市場表現(xiàn)對于提高存儲半導(dǎo)體公司的業(yè)績也有積極的影響���。0Svesmc

SK海力士在7月26日舉行的第二季度業(yè)績發(fā)布會上解釋說,“與上一季度相比���,第二季度DRAM的平均售價(ASP)‘以高個位數(shù)百分比’上漲���,這是由于銷售了許多高附加值產(chǎn)品的影響。”同時披露的財(cái)報也顯示�����,盡管SK海力士第二季度營業(yè)虧損為2.88萬億韓元,但其股價上周卻上漲了12%���。0Svesmc

次日�����,三星宣布第二季度營業(yè)利潤為6685億韓元,同比下降95.26%�。但受益于最新一代HBM3、DDR5芯片等高端內(nèi)存技術(shù)訂單激增的影響�����,三星股價當(dāng)日上漲了2.4%��。0Svesmc

相當(dāng)激進(jìn)的HBM產(chǎn)能規(guī)劃

根據(jù)NVIDIA的定義����,目前DL/ML型AI服務(wù)器平均每臺均搭載4張或8張高端顯卡,搭配兩顆主流型號的x86服務(wù)器CPU����,主要出貨廠商來自于Google、AWS�、Meta�、Microsoft��、百度�、字節(jié)跳動等公司。據(jù)TrendForce集邦咨詢預(yù)估����,今年AI服務(wù)器出貨量年增率可望達(dá)15.4%,2023-2027年AI服務(wù)器出貨量年復(fù)合成長率約12.2%�。0Svesmc

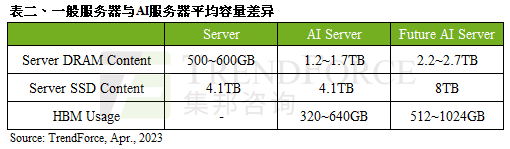

顯而易見,這將大幅帶動存儲器需求成長�����。以現(xiàn)階段一臺標(biāo)準(zhǔn)通用服務(wù)器為例�,其DRAM配置規(guī)模約為500-600GB左右,而AI服務(wù)器在單條模組上可達(dá)64-128GB����,平均容量約為1.2-1.7TB。同時���,由于AI服務(wù)器追求更高的運(yùn)算和傳輸速度���,在接口上會優(yōu)先采用PCIe 5.0��,這使得相較于一般服務(wù)器而言�,AI服務(wù)器會增加GPGPU的使用量�����,因此若以4或8張NVIDIA A100 80GB配置計(jì)算�,HBM用量約為320-640GB?��?梢灶A(yù)見的是,未來在AI大模型日趨復(fù)雜化的趨勢下�����,將刺激更多的存儲器用量�����,并同步帶動服務(wù)器DRAM�����、企業(yè)級SSD和HBM的需求成長。0Svesmc

0Svesmc

0Svesmc

這一趨勢在SK海力士的財(cái)報電話會議上�,得到了首席財(cái)務(wù)官金祐賢(Kim Woohyun)的認(rèn)同。他指出����,隨著以ChatGPT為中心的生成式AI市場的擴(kuò)大,與傳統(tǒng)服務(wù)器相比���,AI服務(wù)器使用的內(nèi)存至少多出1-8倍�����,以實(shí)現(xiàn)更快的計(jì)算處理��,并采用HBM3和DDR5 DRAM等高性能內(nèi)存產(chǎn)品�����,這不僅會推動需求����,而且對盈利能力產(chǎn)生了積極影響����。0Svesmc

他還表示����,雖然全公司投資規(guī)模同比減少50%以上的基調(diào)沒有變化�����,但公司將利用通過經(jīng)營效率化確保的資金���,針對今后主導(dǎo)市場的高容量DDR5���、HBM3 DRAM,持續(xù)投資擴(kuò)大生產(chǎn)能力�。據(jù)BusinessKorea 報道,SK海力士的目標(biāo)是在明年將HBM和DDR5芯片的銷量翻一番�����。0Svesmc

與此同時��,三星也已開始向主要的AI SoC公司和云計(jì)算公司發(fā)貨8層16GB和12層24GB HBM3產(chǎn)品����,并計(jì)劃到2024年將HBM產(chǎn)能增加到2023年的兩倍��。而據(jù)當(dāng)?shù)厝蘇B Securities稱,到2024年���,HBM3將占三星芯片銷售收入的18%���,高于今年預(yù)計(jì)的6%。三星負(fù)責(zé)芯片業(yè)務(wù)的設(shè)備解決方案部門總裁兼負(fù)責(zé)人Kyung Kye-hyun在7月早些時候的公司會議上表示�,三星將努力控制50%以上的HBM市場,高于現(xiàn)在的40%�。0Svesmc

美光最新的DRAM四年路線圖則顯示,其HBM3E預(yù)計(jì)將在2024年第三季度/第四季度開始出貨���,正在開發(fā)的HBMNext內(nèi)存產(chǎn)品將為每個堆棧提供1.5TB/s – 2+TB/s的帶寬�����,容量范圍為36GB至64GB���。0Svesmc

結(jié)語

目前來看,作為一項(xiàng)重要的技術(shù)創(chuàng)新�����,HBM的發(fā)展前景是相當(dāng)光明的��,尤其是在人工智能訓(xùn)練應(yīng)用中。但對比GDDR DRAM動輒16/18Gbps的速率���,HBM3的速率即便達(dá)到9.2Gbps���,也仍然存在差距,而限制HBM發(fā)展的原因則主要來自兩方面:一是中介層�����,二是3D堆疊帶來的復(fù)雜性和制造成本的增加���。但我們相信��,隨著全球存儲三巨頭的深度介入��,上述挑戰(zhàn)終將得到解決�����,HBM市場的激戰(zhàn)也會愈演愈烈。 0Svesmc

責(zé)編:Elaine